虚拟陪伴系统助力盲人独立出行

《世说新语》记载,顾恺之和桓温到殷仲堪家做客,起兴作诗描述最危险的境界。桓说:"矛头淅米剑头炊"(用兵器做饭,能安全吗?);殷说:"百岁老翁攀枯枝"(手脚不便的百岁老人爬上枯树枝,凶险!);顾说:"井上辘轳卧婴儿"(把婴儿放在井口的轱辘轴上,一滚动就掉下深井,更危险!);这三种危险境界真是一种险过一种。但此时一位在座的门客说道:"盲人骑瞎马,夜半临深池。"宾客无不感叹,这种境界最危险。确实,日常生活里,视觉信息占据外界信息的九成,视力障碍给患者的生活带来极大的困难。

全球范围内,研究帮助视障人士出行的辅助装置已经长达半个多世纪。其中,植入式器件试图为盲人重建部分视觉,已经出现了几十种方案,但受限于手术复杂、仅能产生像素很低且模糊的黑白图像、费用高昂等缺陷,迄今还没有一款产品得到大规模的临床应用[1]。多种已经上市的可穿戴式或便携式盲人导航设备产品,如智能盲杖、智能眼镜、导盲机等,运用摄像头、超声雷达、激光雷达、电子地图等技术获取环境图像、用户方位等信息,并通过人工智能(artificial Intelligence,AI)算法将这些信息转化成行动指令,以协助盲人行动。但这些装置大都是"售后不管"的工作模式,主要依赖边缘计算,辨识能力不足,缺乏准确度、安全性、普适性,导致迄今还没有一款这样的盲人导航系统得到广泛应用。而利用网络平台、手机App和随机志愿者服务的"做我的眼睛"(Be My Eyes)公司产品[2],也仅能提供物品辨识、菜单阅读等简单服务,无法提供辅助盲人全程出行的服务。

最近,罗马尼亚公司".lumen"将自动驾驶技术应用于视障人士出行辅助装置,为盲人制造了具有导盲功能的头戴式装置[3]。该装置根据导盲犬的能力进行设计,成本大约5000欧元/套。它通过装配在其上的6个摄像头采集环境图像,并应用同时定位与地图构建(simultaneous localization and mapping,SLAM)、行人语义分割机器学习模型(pedestrian semantic segmentation machine learning model)、路径规划等算法,以三维的方式感知环境。".lumen"的装置已在20多个国家进行初步测试,并在多个国际会议和联合国大楼内展示,按该公司官网介绍其性能达到了自动驾驶汽车性能70% 水平,计划于2024年下半年推向市场,其实际应用效果有待观察。

为什么这些高科技产品还没有被广泛用于盲人的实际生活呢?原因主要有两条。其一,无法应付复杂场景[4]。现代城市里,机动车、非机动车与行人各自通行的路径相互交叠,路况复杂,人行路径上到处分布着台阶、坑洼、垃圾箱、树木、自行车、杂物等多种障碍。仅仅依靠可穿戴设备的AI识别功能,很难应付复杂路况,安全性比较低。例如,现有设备还无法精准判断斑马线两侧的行车距离与速度,完成安全横穿公路的任务。再如,在商场里、在公交车站,识别店家招牌、识别公交车路线与牌号等,也难以仅仅用AI算法来向视障用户提供综合全面的信息。其二,现有工作更多关注盲人的行动指标,而忽视了盲人的真实感受。例如,现有工作测量了装置对用户移动速度的提升,但实际上移动速度并不是视障人士出行的主要需求,大量视障人士总是把"安全可靠"作为出行的第一需求。

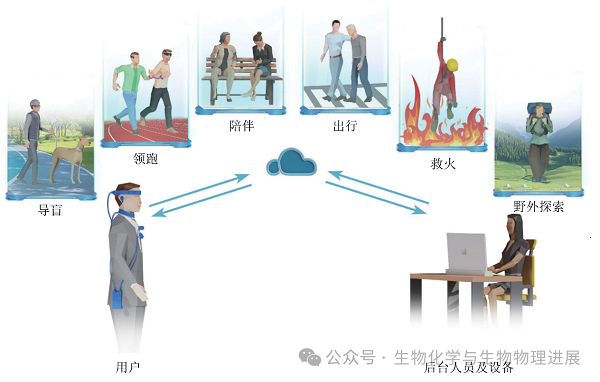

相对于已有的视障人士出行辅助装置,北京大学电子学院许胜勇团队研制的虚拟陪伴系统(remote companion system)充分利用了现有消费级电子产品和商业级网络平台具有的信息采集能力、AI 处理能力、远程通信能力,借助视力正常的后台人员(remote sighted agent,RSA)在长期生活中积累的判断力和判断准确性,为视障人群提供实时、安全可靠的导航等服务,可以帮助视障人士完成独立出行、交友、购物等日常活动[5]。这是一个结合了后台人工服务、云侧AI、端侧AI的系统,经过了三十多位盲人的实地使用测试。该系统不仅可操作性强,易于使用,更能够给予用户较强的安全感和陪伴感,适于推广。(详情请点击阅读原文)

"远程盲人导航和虚拟陪伴系统"由多个装置与功能模块构成,包括视觉图像采集模块、超声雷达避障模块、IMU模块、定位模块、无线通信模块、视觉图像处理模块、触觉编码输出模块、振动马达驱动模块、语音交互模块等。借助融合定位技术、远程无线网络通讯技术,利用使用者随身佩戴的摄像头、超声雷达等传感器,以及云端强大的计算能力,后台人员可以实时、充分、远程地了解前方的现场景象、环境参数、人员状态等信息,从而可以快速分析出最合理的行动方案,并将行动指令及时传给视障使用者。

视障人士或其他有特殊需求的用户佩戴隐蔽的触觉振动装置、耳机等电子设备后,可以在后台人员和云计算帮助下,更加安全高效、心情愉快地完成复杂的生活任务。针对不同的工作场景,后台人员可以使用专用的输入设备,向装置使用者方便地下达触觉指令。这些触觉指令通过无线网络传输到佩戴在用户身上的装置,触发连接在装置上的振动马达,使得多个振动马达按使用者事先学习过、已经熟练掌握的模式进行振动,传递信息。同时,后台人员也实时与用户做语音交流,可以根据情景需要辅助以语音信息,比如描述路径、路况、行人相貌、车牌号、店名、餐桌位置、菜单内容等。因此,该系统的闭环过程由后台人员和用户借助现代的电子装备共同来完成,仿佛后台人员就在用户身边陪伴一样,一起解决复杂问题、完成复杂任务。这是一种充分利用了电子设备的能力和人的智慧的工作模式,极大提高了用户的能力。

本系统利用身体皮肤触觉的天然空间方位感和快速响应的特点,研发了独特的触觉编码指令系统。触觉编码不仅可以准确引导盲人手脚和身体的行动,也能类似摩斯码、手语、旗语等编码语言,在特殊的工作场景下隐蔽地传输信息,具有静默、隐蔽、保护隐私等特点[6]。而触觉和语音相结合的信息传输途径,不仅增加了系统工作的安全性和可靠性,也使得个性化服务得以实现。

实际测试中,应用这套系统服务,模拟全盲用户听从远程后台指令,不仅可以完成人行道步行、上下楼梯、商店购物、过十字路口、乘坐公交车等复杂任务,还可以独立骑自行车。这在世界上是首次报道。

虚拟陪伴系统指引下的骑行

"远程盲人导航与虚拟陪伴系统"还有很大的发展空间。后台人员除了可以提供行动指令,也可辨识人的面部表情、情绪等AI目前无法准确识别并传达的细节,从而提供一定的情感寄托和帮助。比如服务对象为老人时,可以远程陪伴老人去银行、邮局、医院等地方,让老人"独自"出行更加安心;服务对象为小朋友时,可以远程陪伴上学放学,确保出行安全。另一方面,通过进一步应用端侧AI技术,可对突然出现的危险事件作出紧急反应,比如可以通过及时下达紧急停止命令,避开突然闯入行走路径的行人或车辆。端侧AI也可用于丰富视障用户的娱乐生活,有望让视障人士随时可以享受打扑克、打麻将的快乐。更进一步,后台人员可由肢体残障但视力健全的人士承担。当用户群规模扩大时,将为大量残疾人士提供全新的就业机会,为社会提供服务。视觉障碍人群还有望在政府的指导下享受"专门识别"待遇,通过佩戴与汽车、道路设施相互通讯的设备,使得城市可以识别出需要帮助的视障人士,进一步增加他们出行的安全系数。

参考文献

[1] 林衍旎,葛松,杨娜娜,等.人工视觉辅助系统:现状与展望.生物化学与生物物理进展,2021,48(11):1316-1336

[2] By My Eyes. https://www.bemyeyes.com/

[3] .lumen. https://www.dotlumen.com/

[4] El-Taher F E Z, Miralles-Pechuán L, Courtney J, et al. A survey on outdoor navigation applications for people with visual impairments. IEEE Access, 2023, 11: 14647-14666.

[5] Lee S, Yu R, Xie J, et al. Opportunities for human-AI collaboration in remote sighted assistance//27th International Conference on Intelligent User Interfaces. 2022: 63-78

[6] Lin Y N, Li Y C, Ge S, et al. Three-dimensional encoding approach for wearable tactile communication devices. Sensors, 2022, 22(24): 9568

作者简介

李沿橙:北京大学博士研究生。现阶段主要研究人工视觉体外辅助系统。

葛松:北京大学博士研究生。现阶段主要研究脑机接口应用、人工视觉体外辅助系统及视神经系统的信息传递。

许胜勇:北京大学电子学院教授,博士生导师。研究领域为神经信号传输和脑功能物理机制,脑机接口,人工视觉系统。

(作者:李沿橙、葛松、许胜勇)

(本文来源于公众号:生物化学与生物物理进展)

附件下载: