近年来,以深度学习为代表的计算超分辨方法能够在不损失其他成像性能的前提下,提升显微图像分辨率或信噪比,表现出巨大的应用前景。然而,针对生物医学研究必需高保真度、可定量分析的图像要求,目前深度学习显微成像方法存在以下三大共性问题:

(1)受限于深度学习内秉的频谱频移(spectral-bias)问题,输出图像分辨率无法达到真值(ground truth)水平;

(2)受限于超分辨重建以及去噪问题的病态性(ill-posed problem)和神经网络模型的不确定性(model-uncertainty),重建或预测结果的真实性无法得到保障;

(3)深度神经网络的训练需要大量数据,高质量训练数据的采集在许多应用场景下极其困难、甚至无法实现。

由于以上瓶颈,尽管目前深度学习显微成像方法的研究和发展如火如荼,并且表现出了超越传统成像性能极限的巨大潜力,但上述瓶颈问题阻碍了现有深度学习超分辨或去噪方法在生物显微成像实验中的广泛使用。

2022年10月6日,中国科学院生物物理研究所李栋课题组与清华大学自动化系、清华大学脑与认知科学研究院、清华-IDG/麦戈文脑科学研究院戴琼海课题组,联合美国霍华德休斯医学研究所(HHMI)Jennifer Lippincott-Schwartz博士在《Nature Biotechnology》杂志以长文(Article)形式发表题为“Rationalized deep learning super-resolution microscopy for sustained live imaging of rapid subcellular processes”的论文,提出了一套合理化深度学习(rationalized deep learning,rDL)显微成像技术框架,将光学成像模型及物理先验与神经网络结构设计相融合,合理化网络训练、预测过程,从而实现了高性能、高保真的显微图像去噪与超分辨重建,并结合实验室自主研发、搭建的多模态结构光照明显微镜(Multi-SIM)与高速晶格光片显微镜(LLSM),将传统TIRF/GI-SIM、3D-SIM、LLS-SIM和LLSM的成像速度/时程提升30倍以上,实现了当前国际最快(684Hz)、成像时程最长(最长可达3小时、60,000时间点以上)的活体细胞成像性能,首次对高速摆动纤毛(>30Hz)中转运蛋白(IFT)的多种运输行为以及完整细胞分裂过程中核仁液液相分离(liquid-liquid phase separation)过程进行快速、多色、长时程、超分辨观测。《Nature Biotechnology》杂志针对这一工作同时发表了Research Briefing文章进行评述。

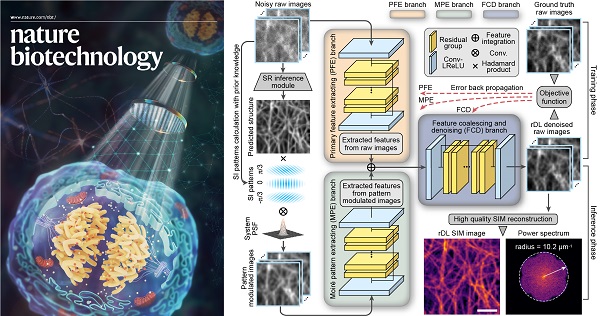

图1 合理化深度学习超分辨显微成像神经网络架构

具体而言,李栋/戴琼海研究团队提出的合理化深度学习结构光超分辨重建架构(rDL SIM)不同于现有超分辨神经网络模型的端到端(end-to-end)训练模式,而是采用分步重建策略,首先利用所提出的融合成像物理模型和结构光照明先验的神经网络对原始SIM图像进行去噪和高频信息增强,然后再通过经典解析算法进行SIM重建以获得最终的超分辨图像。相比于该团队去年在Nature Methods杂志上提出的超分辨重建神经网络模型DFCAN/DFGAN【1】,rDL SIM可将超分辨重建结果的不确定性降低3~5倍,并实现更高的保真度和重建质量;相比于其他去噪算法(如CARE【2】),rDL SIM可完美恢复出调制在原始图像中的莫尔条纹,并将高频信息增强10倍以上。

此外,针对晶格光片显微镜、共聚焦显微镜等宽场照明或点扫描成像模态,该研究团队提出了一种可学习的傅立叶域噪声抑制模块(FNSM),该模块可以利用OTF信息对显微图像中的噪声进行自适应滤除。然后,他们以此构建了嵌入FNSM的通道注意力去噪神经网络架构,并基于显微成像数据本身的时空连续性,提出了时空交织采样自监督训练策略(TiS/SiS-rDL),无需额外采集训练数据、亦无需保证时序数据具有时间连续性,即可实现媲美监督学习效果的去噪神经网络的训练,解决了实际生物成像实验中高质量训练数据难以获取的难题。

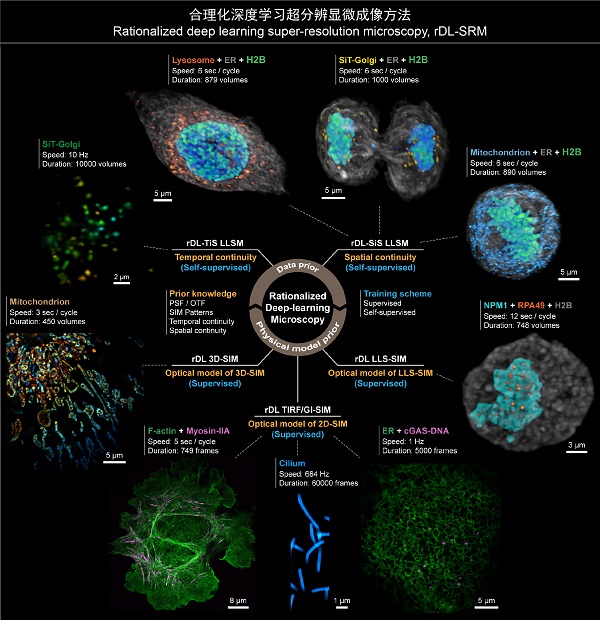

图2 合理化深度学习超分辨显微成像方法应用概览

合理化深度学习超分辨显微成像方法能够适用于包括2D-SIM、3D-SIM、LLSM等在内的多种显微成像模态,提供高分辨率、高保真的显微图像重建性能,相较于传统方法最多可以提升30倍的成像时程和10倍的成像速度。借助rDL成像技术,研究团队进行了诸多过去的成像手段无法开展的超分辨活体成像实验,并与HHMI, Lippincott-Schwartz博士,中科院分子细胞科学卓越中心朱学良研究员、中科院遗传发育所何康敏研究员一起深入探讨了其潜在的生物学意义,包括:

(1)对滴落在玻片上的U2OS细胞贴壁生长过程进行了双色、长时程(1小时以上)、超分辨(97nm分辨率)观测,清晰、真实地记录了细胞粘附和迁移的动力学现象,而不会干扰这一漫长、脆弱的生命过程;

(2)对高速摆动纤毛以当前最快的684Hz成像速率进行了长达60,000个时间点的连续超分辨观测,过程中无明显光漂白或细胞活性损伤,并对纤毛摆动模式和频率进行了统计分析;

(3)对摆动纤毛及纤毛内转运蛋白(IFT)进行了超快、超分辨双色成像,首次揭示了IFT在行进途中碰撞、重组、掉头等多种新行为;

(4)通过对cCAS-DNA与ER进行双色、长时程、超分辨成像,观测到cGAS-DNA在保持与ER持续接触过程中的定向运动、转向或扩散等行为,拓展了对膜性细胞器与无膜细胞器相互作用机制的认知;

(5)对HeLa 细胞分裂过程中的核仁磷酸蛋白(NPM1)、RNA聚合酶I亚基RPA49以及染色质(H2B)进行超长时程(12秒采集间隔,2.5小时以上)的三维超分辨活体成像,首次实现了对完整有丝分裂过程中NPM1与RPA49两种结构形态变化的三维超分辨活体连续观测,揭示了细胞有丝分裂过程中核仁形成以及NPM1、RPA49两种无膜亚细胞结构的相变、互作规律;

(6)以10Hz的全细胞体成像帧率对高尔基体进行了长达10,000时间点的连续拍摄,并实现了对完整细胞分裂过程内质网、溶酶体、线粒体等亚细胞结构的三色、高速(秒量级)、超长时程(小时量级,>1000个时间点)三维观测,深入探究了细胞有丝分裂过程中细胞器在子代细胞中的均匀分配机制。

综上所述,李栋/戴琼海合作团队通过人工智能算法与光学显微成像技术的交叉创新,提出了一种合理化深度学习超分辨显微成像框架,解决了现有深度学习成像方法分辨率损失、预测不确定性、训练集不易采集等难题,能够为多种活体显微成像模态提供30倍以上的成像速度与时程的提升,为细胞生物学、发育生物学、神经科学等领域的发展提供了重要的研究工具,而该研究团队所坚持和倡导的人工智能算法与光学成像原理交叉创新、软硬结合的研究思路也为现代光学显微成像的发展开辟了新的技术路径。

清华大学自动化系博士后乔畅、中国科学院生物物理所正高级工程师李迪、助理研究员刘勇、张思微为该论文共同第一作者,中国科学院生物物理所研究员李栋、清华大学自动化系教授戴琼海和霍华德休斯医学研究所研究员Jennifer Lippincott-Schwartz为共同通讯作者。本研究得到了国家自然科学基金委、科技部、中国科学院、中国博士后科学基金、腾讯"科学探索奖"、清华大学"水木学者"计划的资助。

文章链接:https://www.nature.com/articles/s41587-022-01471-3

(供稿: 李栋研究组)

附件下载:

附件下载: